En este capítulo se desarrollarán con algún detalle, algunos ejemplos tomados de autores cuya posición se enmarca dentro de lo que aquí se ha denominado neomecanicismo. Los ejemplos han sido escogidos, deliberadamente, de diferentes disciplinas. El objetivo es mostrar que la búsqueda de mecanismos (más allá del empleo del término mecanismo) es ubicuo en la ciencia contemporánea: se trata de un movimiento que atañe a la ciencia como empresa y no es privativo de las ciencias sociales, las ciencias conductuales o las ciencias de la vida.

Los ejemplos elegidos son los aportados por quienes investigan y se encuentran en textos científicos, en textos filosóficos y/o en manuales. Este capítulo tiene un doble propósito: por una parte, los ejemplos mostrarán cómo se trabaja (investiga, teoriza, explica) utilizando mecanismos. Por ello, se presentarán los ejemplos, en lo posible, en los términos en que los describen quienes investigan. Esto permitirá entender mejor qué tienen en mente, qué definiciones, caracterizaciones y conceptos subyacen a la investigación. Por otra parte, los ejemplos permitirán evaluar, más adelante, distintas caracterizaciones que se han dado de mecanismo. En el capítulo 3 se expondrán algunas de estas caracterizaciones dadas por distintos neomecanicistas para mostrar la diversidad y la falta de acuerdo al respecto. Se analizarán las caracterizaciones a la luz de los ejemplos que se exponen en este capítulo, y se mostrará que no resultan aptas, por diversos motivos, como núcleo de la propuesta neomecanicista.

1. Mecanismo de formación de creencias

Desarrollado por Hedström y Swedberg (1996, 1998b), el mecanismo de formación de creencias es el mecanismo que subyace a tres fenómenos sociales diferentes: la profecía autocumplida, los procesos de difusión en red (network diffusion processes) y el umbral de la acción colectiva.

Se produce una profecía autocumplida (Merton, 1968) cuando una predicción, inesperable (o infundada) en el momento en que se concibe, toma estado público y provoca en los agentes un cambio de conducta tal que la predicción resulta luego verdadera. Por ejemplo, se difunde un rumor sobre la posible quiebra de un banco (que de hecho no está en riesgo, dado que está operando normalmente y no es esperable que quiebre en el corto plazo). Los ahorristas que creen en la cercana quiebra del banco se apresuran a retirar sus ahorros (lo cual refuerza el rumor y hace que más y más gente desconfíe del banco y retire sus ahorros). Finalmente, el banco no puede afrontar el retiro súbito de tantos ahorristas y quiebra.

El estudio de los procesos de difusión en red se inspira en los trabajos de Coleman, Katz y Menzel (1957; 1966) sobre la difusión de una nueva droga y se extiende a diversas ramas de la sociología (Burt, 1987; Hedström 1994; Marsden y Podolny, 1990; Strang y Tuma, 1993). En el ejemplo de la difusión de la nueva droga, se encontró que las opiniones de los médicos en distintas redes profesionales influyeron en el proceso de difusión de la droga, especialmente durante el período inmediatamente posterior a la introducción de la nueva droga en el mercado. El argumento que explica este fenómeno es que la información sobre innovaciones se difunde a través de las redes de comunicación, y la propensión individual a adoptar una innovación se ve influida por lo que los demás hacen, particularmente cuando hay un alto grado de incertidumbre sobre el verdadero valor de las innovaciones.

Según la teoría del umbral de la conducta colectiva (Granovetter, 1978; Granovetter y Soong, 1983), la decisión de un individuo de participar o no en cierta acción colectiva usualmente depende, al menos en parte, de cuántos otros actores ya hayan decidido participar. Por ejemplo, al decidirse a entrar a un restorán desconocido, el número de gente que haya comiendo en ese momento gravitará en la decisión. El número de actores que ya deben estar comprometidos con la acción difiere en cada individuo, por eso Granovetter introduce el concepto de umbral individual: el umbral individual denota qué proporción del grupo debe estar previamente comprometido para que el individuo se sume a la acción colectiva. Pequeñas variaciones en el umbral de los individuos pueden llevar a grandes diferencias en los resultados colectivos.

Para analizar y mostrar el mecanismo que subyace a estos tres ejemplos, Hedström y Swedberg introducen una formalización. Sean:

Pit = propensión del individuo i a realizar en el instante t el acto analizado (retirar los ahorros del banco, adoptar una nueva droga, visitar un restaurant, etc.).

bit = la fuerza de la creencia del individuo i en el valor o necesidad de realizar en el instante t el acto analizado.

Merton, Coleman y Granovetter asumen que los individuos dirigen sus acciones según sus objetivos, y que la propensión individual a ejecutar la acción en cuestión es una función f de la creencia del individuo en el valor de ejecutar el acto:

Pit = f (bit)

A los tres ejemplos subyace una misma idea: la creencia del individuo i en el valor o necesidad de ejecutar un acto en el instante t es una función del número de individuos que ejecutan el acto en el instante t – 1. Es decir, se asume que

bit = g (nt – 1)

donde nt es el número de individuos que ejecutan el acto en el instante t y g es una función creciente.

Sustituyendo en la primera fórmula esta igualdad, se obtiene:

Pit = f [g (nt – 1)]

La diferencia entre las tres teorías expuestas está en la función g, que es la que influirá en algunos efectos agregados, pero el mecanismo principal (puede haber otros secundarios o tangenciales) es el mismo para las tres teorías.

2. Bombeo de sangre

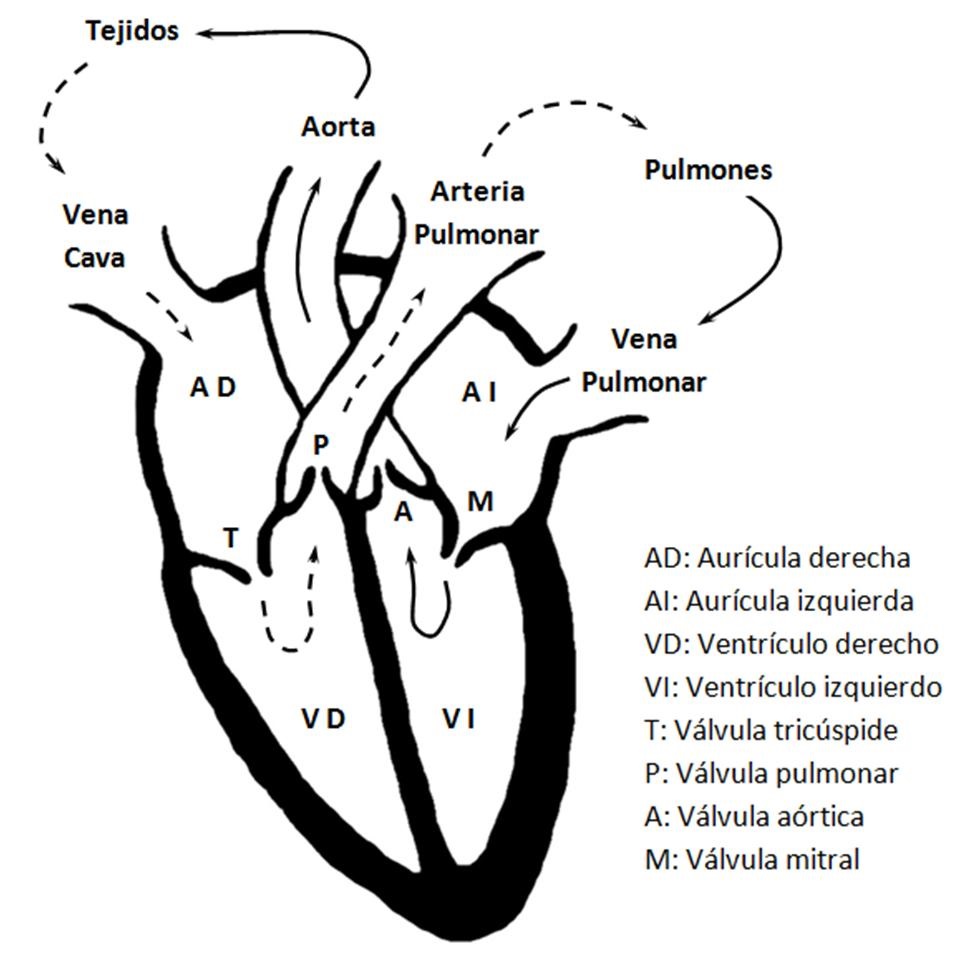

Bechtel y Abrahamsen (2005) dan como ejemplo el mecanismo de bombeo de la sangre (enmarcado en el sistema circulatorio).

El corazón (ver figura 2) está formado por cuatro cavidades: las aurículas derecha e izquierda y los ventrículos derecho e izquierdo. El lado derecho del corazón bombea sangre (carente de oxígeno procedente de los tejidos) hacia los pulmones donde se oxigena; el lado izquierdo del corazón recibe la sangre oxigenada de los pulmones y la impulsa a través de las arterias a todos los tejidos del organismo.

Figura 2

La sangre procedente de todo el organismo llega a la aurícula derecha a través de la vena cava (de hecho, son dos que se unen: la vena cava superior y la vena cava inferior). Cuando la aurícula derecha se contrae, impulsa la sangre a través de la válvula tricúspide hacia el ventrículo derecho. La contracción de este ventrículo conduce la sangre por la arteria pulmonar hacia los pulmones. La válvula tricúspide evita el reflujo de sangre hacia la aurícula, ya que se cierra por completo durante la contracción del ventrículo derecho. La válvula pulmonar evita el reflujo de la sangre hacia el ventrículo derecho.

En su recorrido a través de los pulmones, la sangre se oxigena (nótese que, para el mecanismo de bombeo en sí, la oxigenación de la sangre no es relevante, aunque lo sea para el sistema circulatorio). Después regresa al corazón por medio de la vena pulmonar (son, de hecho, cuatro venas que confluyen) que desemboca en la aurícula izquierda. Cuando esta cavidad se contrae, la sangre pasa al ventrículo izquierdo y desde allí a la aorta gracias a la contracción ventricular. La válvula mitral evita el reflujo de sangre hacia la aurícula y la válvula aórtica evita el reflujo hacia el ventrículo.

La actividad del corazón consiste en la alternancia sucesiva de contracción (sístole) y relajación (diástole) de las paredes musculares de las aurículas y los ventrículos. Durante el período de relajación, la sangre fluye desde las venas hacia las dos aurículas, y las dilata de forma gradual. Al final de este período la dilatación de las aurículas es completa. Sus paredes musculares se contraen e impulsan todo su contenido hacia los ventrículos.

La sístole ventricular sigue de inmediato a la sístole auricular. La contracción ventricular es más lenta, pero más enérgica. Las cavidades ventriculares se vacían casi por completo con cada sístole.

3. Mecanismo de transmisión química en la sinapsis

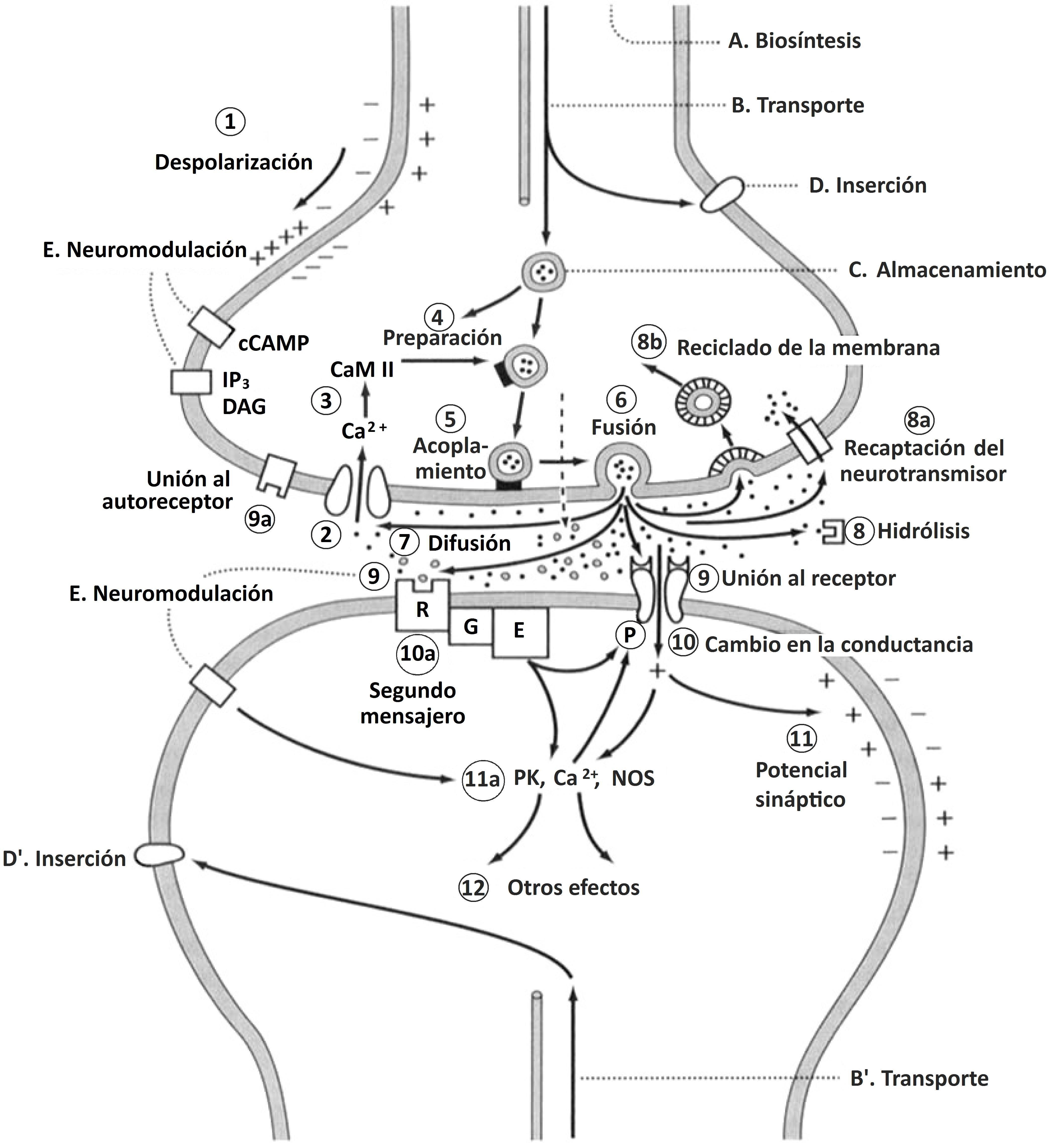

Machamer, Darden y Craver (2000)[1] toman como ejemplo el mecanismo de transmisión química en la sinapsis.

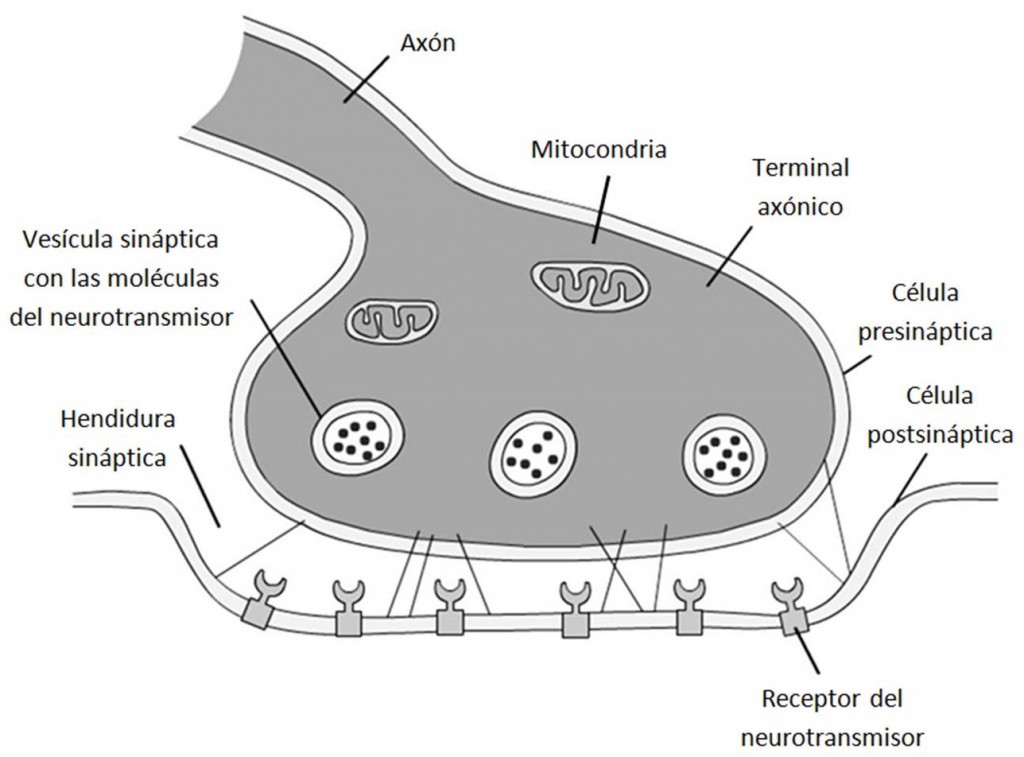

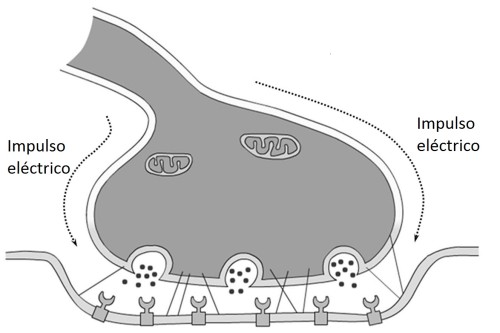

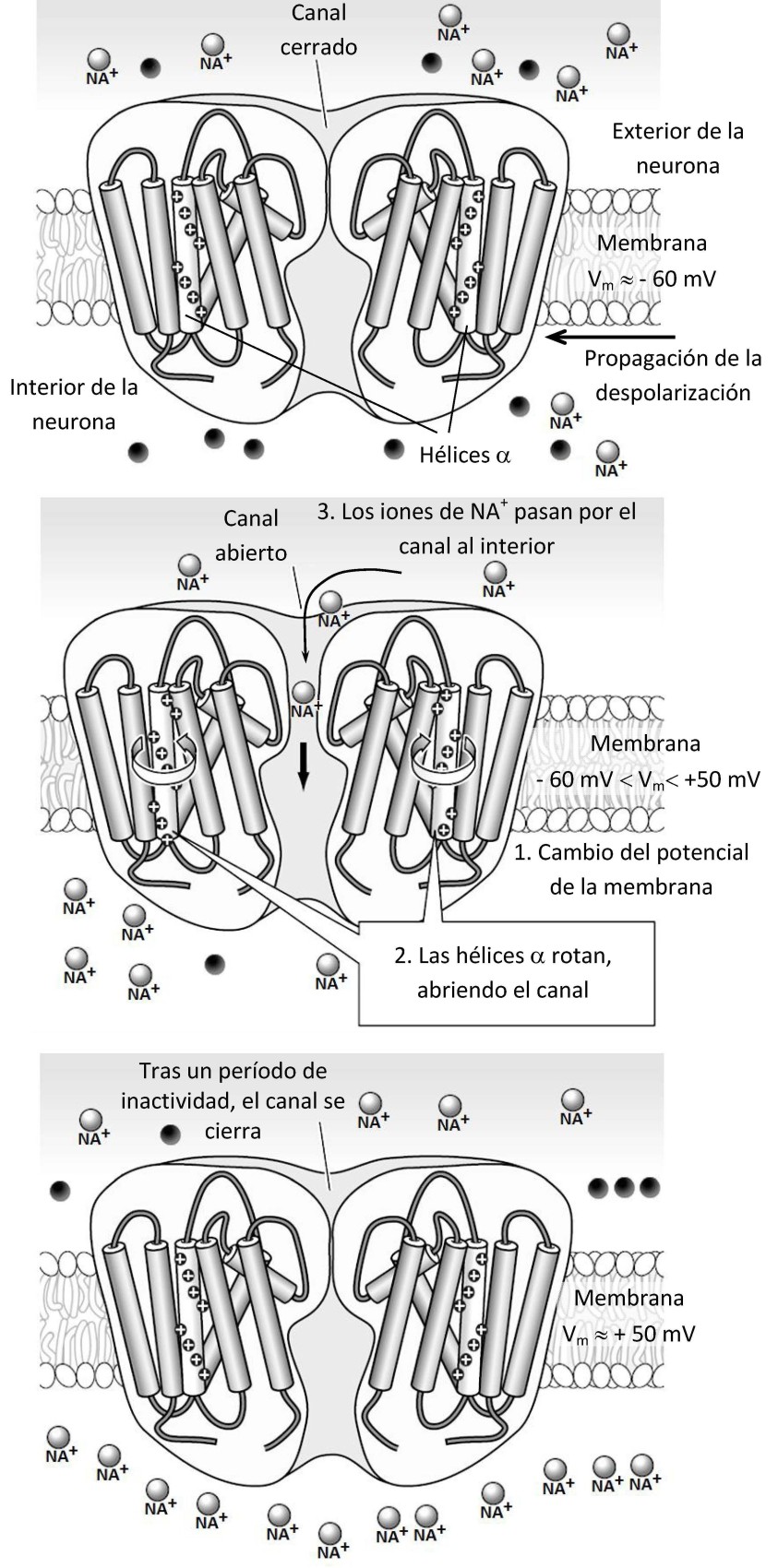

La sinapsis es un contacto entre dos neuronas, en el cual una neurona (la presináptica) emite una señal que influye en la otra (la postsináptica). Hay dos tipos: la sinapsis eléctrica (la señal que se transmite es directamente un impulso eléctrico) y la química (que se desarrollará a continuación). La figura 3 esquematiza el proceso completo de la transmisión química, entendida abstractamente como la conversión, en una neurona, de una señal eléctrica en una señal química.

Figura 3

En la sinapsis química las neuronas están eléctricamente aisladas ya que se hallan separadas por un hiato denominado “hendidura sináptica”, como puede verse (junto a los elementos básicos de las neuronas que intervienen en el proceso) en la figura 4.1. Por estar eléctricamente asiladas, la transmisión de la señal no puede darse directamente por el paso de un impulso eléctrico, como sucede en la sinapsis eléctrica.

Figura 4.1

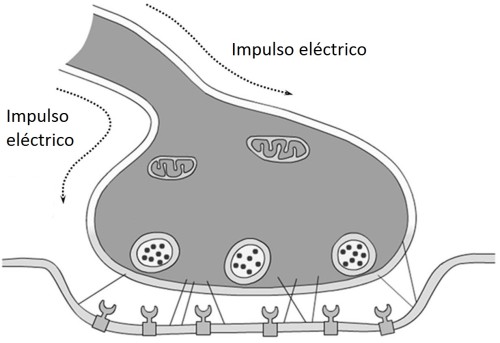

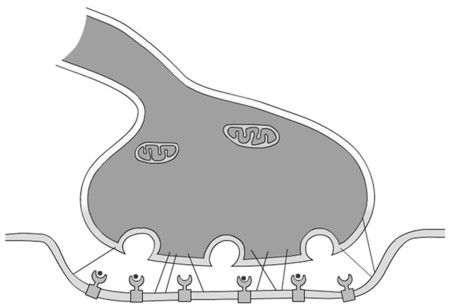

La sinapsis química comienza con la llegada de un potencial de acción en el terminal axónico (figura 4.2).

Figura 4.2

Un potencial de acción es un cambio transitorio en el potencial eléctrico a través de una membrana; este cambio da como resultado en las neuronas la conducción de un impulso eléctrico (el sentido del desplazamiento de este impulso se indica en la figura 4.2 con una flecha).

Figura 4.3

El arribo del potencial de acción inicia la fusión de las vesículas sinápticas con la membrana presináptica, liberando los neurotransmisores en la hendidura sináptica (figura 4.3). Las membranas presináptica y postsináptica están ancladas por una red proteica en la hendidura sináptica (representado en las figuras por líneas finas).

Figura 4.4

Los neurotransmisores se difunden a través de la hendidura sináptica y se unen a la célula postsináptica, donde se combinan con receptores específicos de la membrana celular (figura 4.4).

Después de su liberación, los neurotransmisores que no actuaron son rápidamente recaptados o destruidos, y su efecto se interrumpe. Al unirse a los receptores, los neurotransmisores causan un cambio, ya que abren o cierran canales en la membrana que modifican el flujo de iones, lo cual altera la conductancia de la membrana postsináptica. Así se transmite la señal de una neurona a otra.

Esta breve caracterización de la sinapsis química puede resumirse en tres etapas, tal como se indica en la figura 4.5.

Figura 4.5

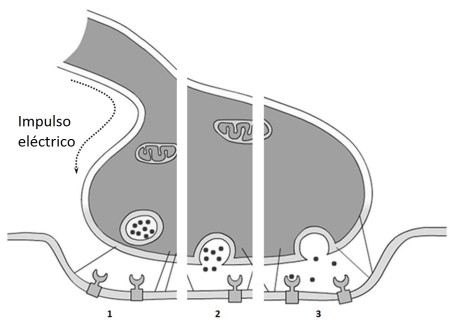

La figura 3 intenta reunir todos los procesos, mecanismos y etapas que involucra la sinapsis química. La primera etapa, conocida como “despolarización” (etapa 1 de la figura 3) es la que se analiza y discute detalladamente en los trabajos citados más arriba. Se dice que en estado de reposo una neurona está polarizada porque el interior de la membrana celular tiene una carga eléctrica negativa con respecto al exterior. El líquido extracelular tiene una gran concentración de iones de sodio (Na+) y la concentración de iones de potasio (K+) es baja. Por el contrario, en el citoplasma de la neurona hay una alta concentración de K+ y una baja concentración de Na+. La membrana neuronal en reposo es poco permeable al Na+, y las bombas de membrana mantienen un gradiente electroquímico importante para el Na+; por el contrario, la membrana en reposo es altamente permeable al K+ (en otras palabras: los iones positivos de Na+ no pueden entrar, mientras que los iones positivos de K+ pueden salir; por eso la carga es menor en el interior). En la figura 3, esto está representado con signos más (+) y menos (–) a cada lado de la membrana (la flecha indica la propagación de la despolarización: las cargas se van invirtiendo “desde arriba y hacia abajo”). La membrana contiene transportadores activos (proteínas) que producen y mantienen los gradientes (la variación sistemática de la concentración de iones). La más importante es la bomba de Na+/K+, que hidroliza una molécula rica en energía, el ATP (trifosfato de adenosina o adenosín trifosfato), para mantener los niveles intracelulares, tanto de Na+ como de K+[2].

En estado de reposo, en el cual las neuronas están eléctricamente polarizadas, la diferencia de potencial es de aproximadamente –70 m V (el fluido interior de la membrana celular está cargado negativamente con respecto al líquido exterior a la célula). La despolarización es el cambio positivo en el potencial de la membrana. Los canales selectivos de Na+ son sensibles al voltaje y, puesto que son selectivos, solo los iones de sodio pueden pasar a través de ellos. Los canales contienen las llamadas “hélices α”, conglomerados de aminoácidos agrupados helicoidalmente con carga positiva en un lado de la hélice. Esto actúa como un sensor que detecta los cambios en el potencial eléctrico a través de la membrana. Cuando la hélice detecta el cambio de potencial, sufre un cambio en su conformación, como si rotara, lo cual abre el canal. Las neuronas se despolarizan cuando los canales selectivos de Na+ se abren en la membrana, permitiendo que el Na+ pase al interior de la célula por difusión y atracción eléctrica. Los cambios resultantes en la distribución de iones hacen que el fluido intracelular progresivamente pierda negatividad hasta llegar a tener, en algún momento, mayor carga positiva que el fluido extracelular (con picos aproximados de + 50 m V). Las etapas de este pasaje de Na+ por los canales pueden sintetizarse en la figura 4.6 (y serían una ampliación del punto 1 de la figura 3). A esta primera etapa, sigue una elevación de la permeabilidad secundaria de la membrana al K+, que sale a través de la membrana, lo cual repolariza exageradamente la neurona por un período breve, haciendo que el potencial de membrana se repolarice con rapidez y alcance pronto los niveles de reposo.

Figura 4.6

4. Fotosíntesis

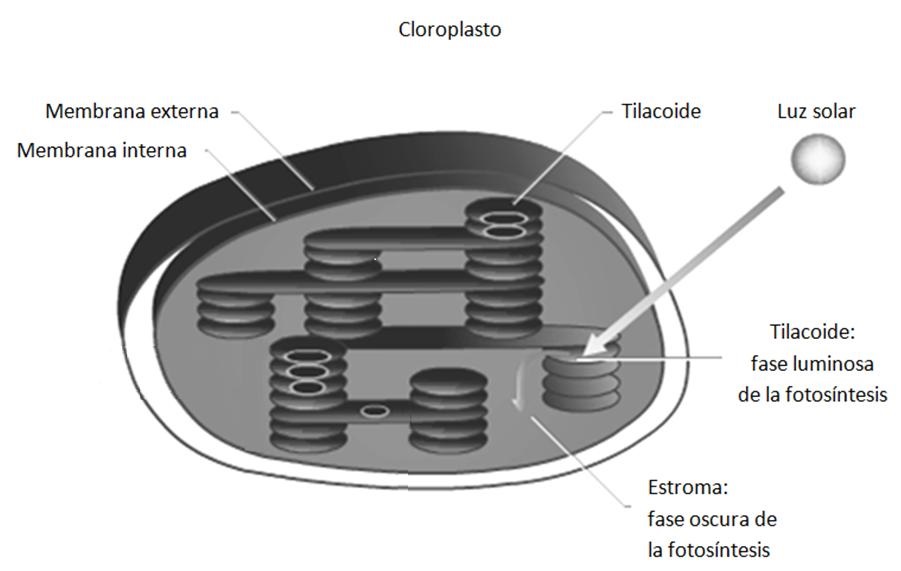

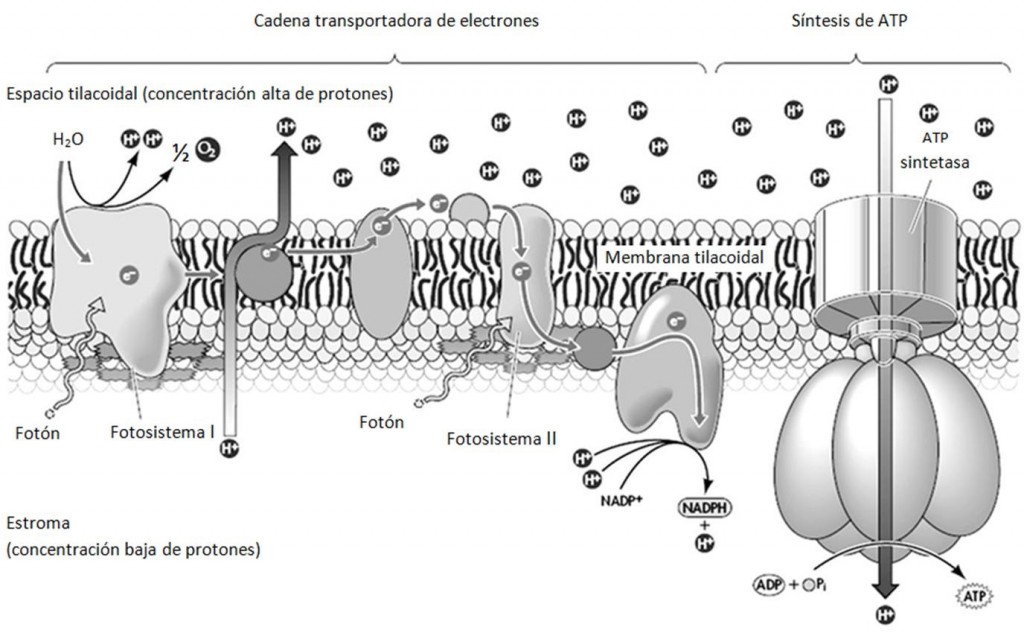

Tabery (2004) desarrolla como ejemplo de mecanismo la primera parte del proceso de fotosíntesis, el proceso de transformar energía lumínica en energía química (más tarde en el proceso, esta energía química es usada para producir carbohidratos). A esta primera parte de la fotosíntesis se la denomina “fase luminosa” (ver figura 5.1).

Figura 5.1

En esta primera etapa la luz es absorbida por las moléculas de clorofila compactadas en los tilacoides del cloroplasto. Aquí los fotones son absorbidos por las moléculas de pigmentos que conforman el complejo denominado “Fotosistema II”. La absorción de esta energía lumínica excita electrones en el Fotosistema II, que son captados por la cadena de transporte de electrones. A medida que los electrones son transportados, la energía liberada es usada para bombear iones de hidrógeno (H+) a través de la membrana tilacoidal, lo que crea una carga positiva dentro del tilacoide, y produce una fuerza motriz de protones. Mientras estos protones pasan a través de la membrana tilacoidal por ósmosis, la energía química en la forma de ATP (trifosfato de adenosina o adenosín trifosfato) es generada por los complejos de ATP sintetasa (luego, en la fase oscura, que tiene lugar en el estroma de los cloroplastos, el ATP se usa para reducir el dióxido de carbono a carbono orgánico). La figura 5.2 esquematiza este mecanismo.

Figura 5.2

5. Evolución: Littorina obtusata

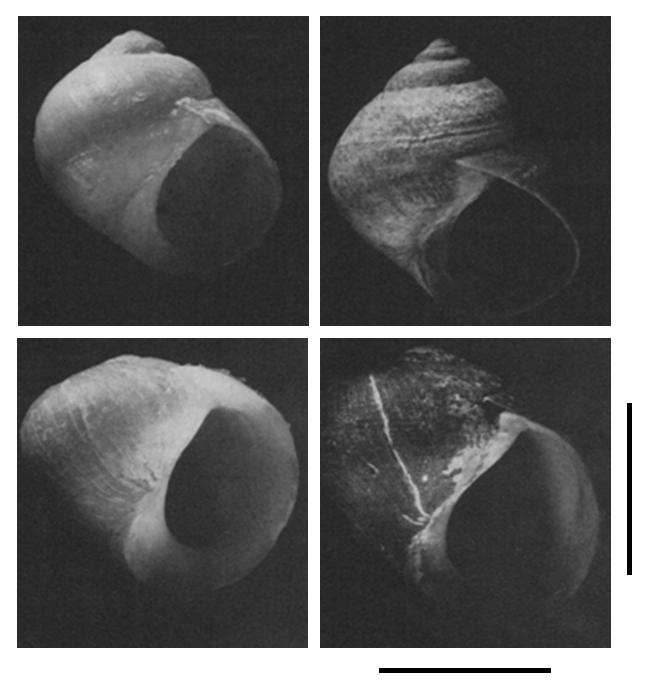

Seeley (1986) analiza el rápido cambio en una especie de caracol marino común denominado flat periwinkle, cuyo nombre científico es Littorina obtusata. Entre 1871 y 1984, la estructura del caparazón en algunas poblaciones de L. obtusata en aguas al norte de Nueva Inglaterra cambió dramáticamente. En 1871, predominaban los caparazones de espira alta y paredes delgadas (véase la figura 6): esto se sabe porque en los museos locales se conservan numerosos caparazones de estos caracoles. En 1984, Seeley constató in situ que predominaban los caparazones de espira baja y paredes gruesas. Este tipo de cambio súbito es raramente observado en biología, y las causas de tales cambios son indetectables en el registro fósil.

Arriba: ejemplares de espira alta y pared fina. Abajo: ejemplares de espira baja y pared gruesa. Barra: 5 mm.

Figura 6

Seeley sostiene que el cambio en la estructura de los caracoles se debió a la selección natural iniciada por la aparición en el área, hacia el año 1900, de un cangrejo que depreda al L. obtusata: el Carcinus maenas. Pueden encontrarse[3] L. obtusata con caparazón de espira alta en algunas localidades de Maine, donde no está presente el C. maenas. Los C. maenas utilizan sus pinzas para romper el caparazón del L. obtusata, y los estudios de laboratorio mostraron que los caparazones de espira alta y paredes delgadas son más vulnerables a las pinzas del C. maenas que los caparazones de espira baja y paredes gruesas. Por las diferencias de altura de la espira y grosor de la pared del caparazón, se pensó que podría tratarse de dos especies distintas (L. obtusata y L. palliata), pero los análisis genéticos mostraron que las poblaciones de caracoles de espira alta y baja no están reproductivamente aisladas: se reproducen entre sí y son, por ende, de la misma especie.

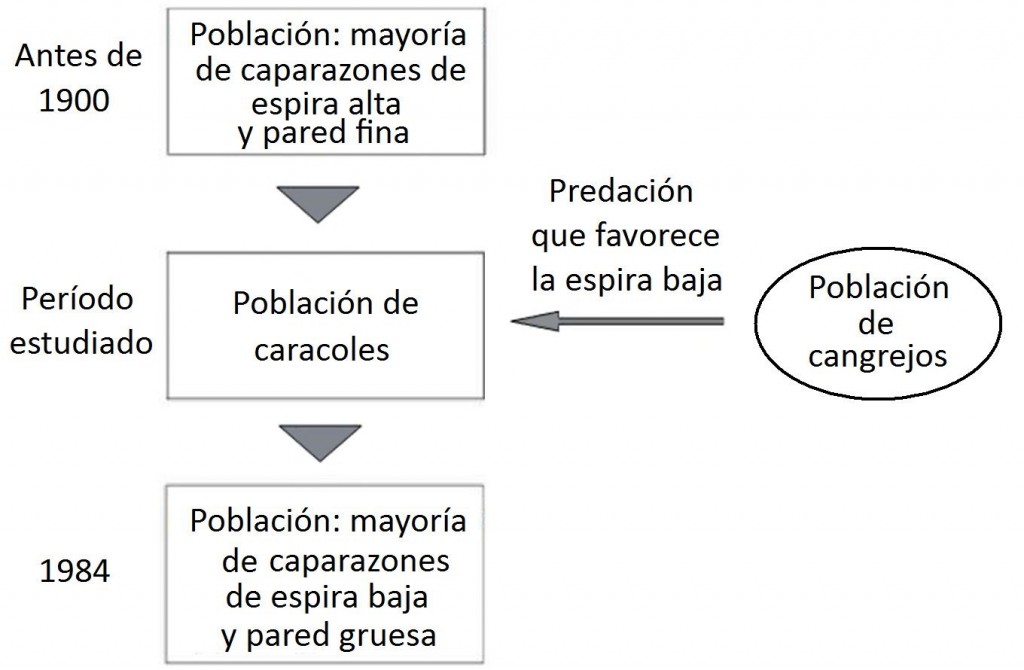

Figura 7

Seeley concluye que la variación en L. obtusata es producto de la Selección Direccional (por la predación del C. maenas)[4], dado que: (a) antes de 1900 la mayoría de los caparazones de L. obtusata presentaban espira alta y pared delgada, (b) el C. maenas aparece en la región hacia 1900, (c) las formas de espira alta y pared delgada de L. obtusata son mucho más vulnerables que las formas de espira baja y pared gruesa al ataque de C. maenas, y (d) en 1984 la mayoría de los caparazones eran de espira baja y pared gruesa.

Este ejemplo es utilizado por Barros (2008) como ejemplo en la discusión con Skipper y Millstein (2005) sobre la selección natural como mecanismo[5].

La reconstrucción que hace Barros del ejemplo estudiado por Seeley se vuelca en el esquema de la figura 7.

6. Democratización

Collier (1999) compara 38 episodios de democratización en 27 países. Yashar (1997) estudia la democratización en Costa Rica y Guatemala desde la década de 1870 hasta la década de 1950. Sobre estos procesos de democratización Tilly (2001b) reconstruye el mecanismo de democratización.

La democracia es definida como consulta protegida: relaciones entre agentes y sujetos de un gobierno, en las cuales:

(a) diferentes categorías de sujetos disfrutan de acceso relativamente amplio e igualitario a los agentes,

(b) la disposición gubernamental de personas, actividades y recursos dentro de las competencias de quien gobierna responde a consultas vinculantes a los sujetos, y

(c) los sujetos reciben protección contra la acción arbitraria de los agentes gubernamentales.

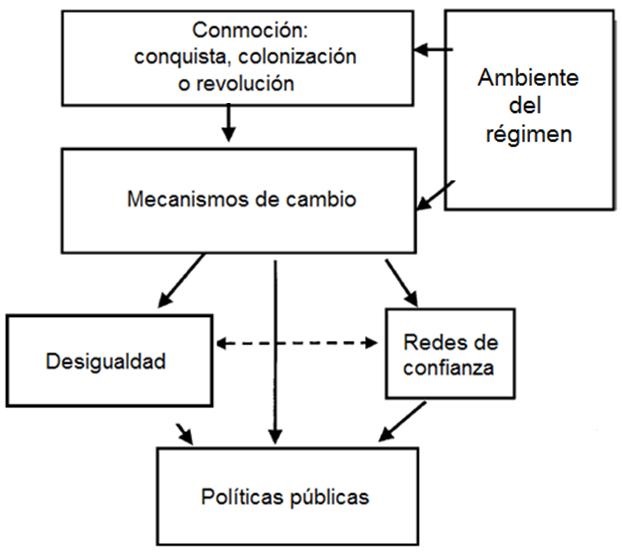

La democratización es un pasaje a la consulta protegida; la des-democratización es la salida de la consulta protegida; emerge de los cambios entre tres conjuntos de relaciones sociales: las políticas públicas, la desigualdad y las redes de confianza. Estos tres conjuntos interactúan y son interdependientes, pero analíticamente separables. Durante la democratización, el grueso de la población de los sujetos del gobierno obtiene derechos protegidos, relativamente iguales, sobre los agentes, las actividades y los recursos del gobierno. En relación con el proceso anterior, la desigualdad en las categorías decrece en las áreas de la vida social que apoyan la participación en las políticas públicas. Por último, un cambio significativo ocurre en la localización de las redes interpersonales en las cuales la gente confía cuando emprende iniciativas riesgosas o a largo plazo, como el matrimonio o la inversión de ahorros; las redes que se localizaban en la evasión al control y a la detección gubernamental pasan a los agentes gubernamentales y se presume que tales agentes cumplirán sus compromisos a largo plazo. Solo cuando los tres grupos de cambios se efectivizan, surge la democracia duradera.

La figura 8 resume el argumento en términos generales.

Figura 8

Una variedad de cambios, que pueden agruparse bajo el rótulo de “ambiente del régimen”, activan mecanismos que, a su vez, generan alteraciones crecientes en las políticas públicas, la desigualdad y las redes de confianza. Los cambios en la desigualdad y en las redes de confianza tienen efectos independientes de las políticas públicas. El ambiente del régimen también produce conmociones ocasionales en la forma de conquista, confrontación, colonización o revolución. Tales conmociones aceleran los mecanismos de cambio y causan alteraciones relativamente rápidas en las políticas públicas, desigualdad y redes de confianza. Sean incrementales o abruptas, estas alteraciones interactúan. Bajo condiciones raras, pero especificables, estas interacciones llevan a la democratización, que no es un producto –sostiene Tilly– sino una condición especial de las políticas públicas.

Los mecanismos que producen los cambios en cuestión son diversos. Tilly los agrupa en tres categorías, según el conjunto de relaciones sociales que cambian.

Ejemplos de mecanismos que provocan cambios en la desigualdad:

– La educación y la comunicación, que suplantan los modelos existentes de organización y, por ende, alteran la emulación de la desigualdad en el momento de la formación de nuevas organizaciones

– La disolución de los controles coercitivos en los cuales se basan las relaciones vigentes de explotación y escasez de oportunidades

Ejemplos de mecanismos que provocan cambios en las redes de confianza:

– La creación de garantías externas para los compromisos de gobierno

– La incorporación y expansión de las redes de confianza existente en el estado

– La desintegración de las redes de confianza vigentes

Ejemplos de mecanismos que provocan cambios en las políticas públicas:

– La formación de coaliciones entre segmentos de las clases dominantes y actores políticos consolidados que no se encuentran en el poder

– El rompimiento de coaliciones sobre categorías desiguales y/o distintas redes de confianza

– La contención burocrática de las fuerzas militares previamente autónomas

7. Mecanismo causante del cáncer o de la producción de úlcera de duodeno

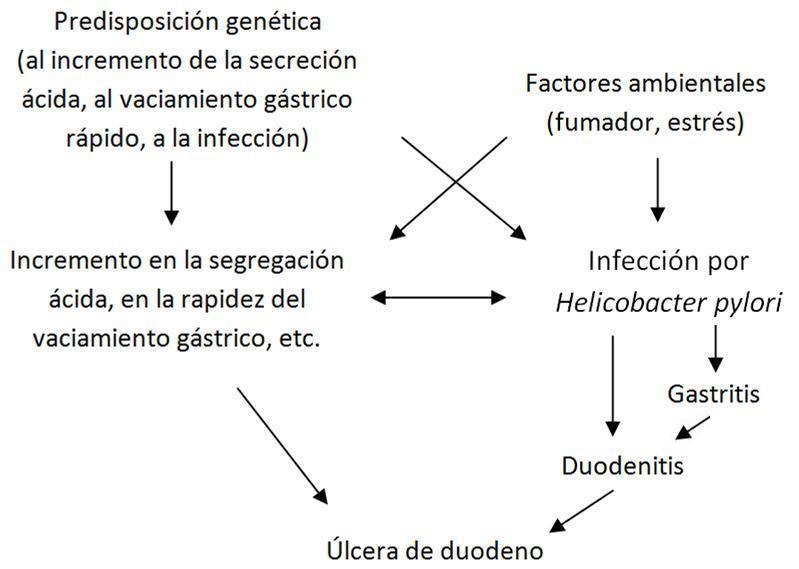

Thagard (1998) sostiene que la explicación de por qué una determinada persona desarrolla cierta enfermedad consiste en la especificación o concretización de una red causal que describe las interrelaciones entre los múltiples factores que culminan en la enfermedad. Los puntos de intersección (o “nodos”) de esa red son las circunstancias o agentes que, en conjunto o separadamente (eso lo detalla la red), pueden dar lugar a la afección. La especificación consiste en precisar, hipotéticamente o sobre la base de observaciones, cuáles son los factores que están presentes en la persona cuya enfermedad se considera; es decir, la explicación indica cuáles de los nodos de la red (abstracta o general) realmente se dan en el paciente. Para un grupo de personas (como mujeres, dentistas, o fumadores) que tienden a padecer determinada enfermedad, la explicación también es la concretización de una red causal, solo que en este caso se indican las condiciones comunes al grupo, no las de un individuo particular. Thagard presenta como ejemplo la úlcera de duodeno. La teoría bacterial de la úlcera de duodeno se originó en 1982 cuando los médicos Barry Marshall y J. Robin Warren establecieron la asociación entre infección con Helicobacter pylori (una bacteria descubierta por Marshall en 1979) y úlcera de duodeno (Marshall, 1989). Marshall y Warren estudiaron (vía estudio endoscópico) la correlación entre 100 pacientes, y aunque no pudieron establecer una relación causa-efecto entre la bacteria y las úlceras (Marshall y Warren, 1984, p. 1314), descubrieron que erradicando la bacteria se curaba la úlcera, es decir, probaron que la infección bacteriana está causalmente relacionada con las úlceras y se recomendó el tratamiento con antibióticos. Los resultados fueron vistos con algún escepticismo por otros médicos, dado que los síntomas de la úlcera se aliviaban con antiácidos (y la explicación alternativa de la enfermedad sostenía que las úlceras eran causadas por exceso de acidez). Se pensaba que los ácidos del estómago matarían la bacteria y que, por lo tanto, los datos obtenidos por Marshall y Warren se deberían a, por ejemplo, una contaminación de las muestras. Pero más y más médicos observaron la bacteria en las muestras, y más y más médicos replicaron la experiencia de Marshall y Warren: erradicar la H. pylori usualmente curaba la úlcera. Además, se descubrió que la H. pylori secreta amoníaco, lo que neutraliza los ácidos y permite la supervivencia de la bacteria en el estómago.

Los investigadores han estado preocupados por el mecanismo mediante el cual la infección con H. pylori produce úlceras. La figura 9.1 representa un mecanismo similar al propuesto por Graham (1989) en el que se pueden apreciar algunas de las interacciones entre herencia, ambiente, infección y ulceración. La investigación busca llenar los huecos entre estos procesos (Olbe, Hamlet, Dalenbäck y Fändriks, 1996).

Figura 9.1

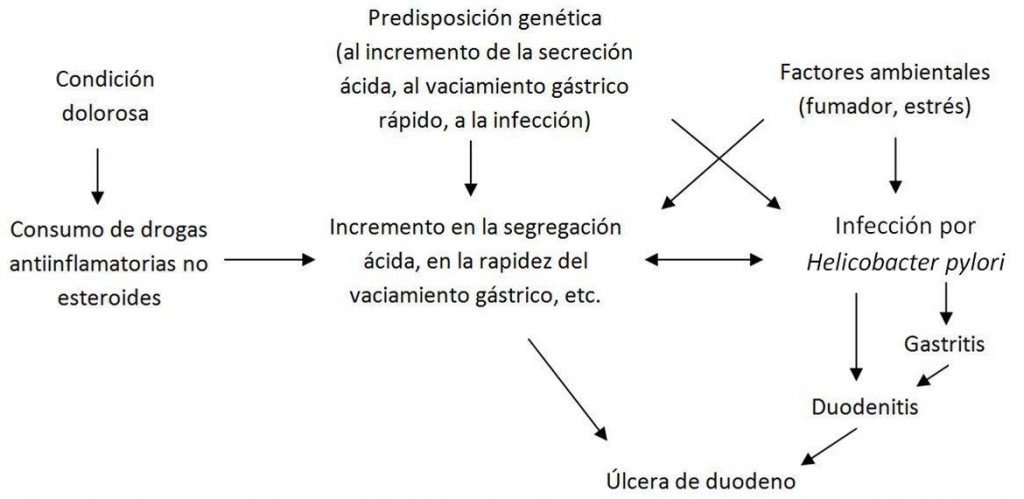

Pero el mecanismo es solo plausible. Es decir, aunque hay una correlación entre las úlceras de duodeno y la infección con H. pylori, no puede concluirse inmediatamente que una persona que padece úlceras tiene una infección: aproximadamente el 20 % de las úlceras son causadas por el uso de antiinflamatorios no esteroides, como la aspirina. El esquema completo sería el de la figura 9.2.

El mecanismo es complejo. Thagard concluye que la explicación de por qué una persona determinada tiene la enfermedad debe concretizar esta red (es decir, incluir solo los nodos efectivamente involucrados en ese caso particular), para lo cual es menester determinar si el paciente, por ejemplo, consume drogas antiinflamatorias no esteroides o tiene una tendencia al exceso de acidez. Esta especificación de la red causal debe estar respaldada por la observación (de la conducta o de los antecedentes de la persona) o bien por la corroboración de las hipótesis (una endoscopía que determine la infección con H. pylori).

Figura 9.2

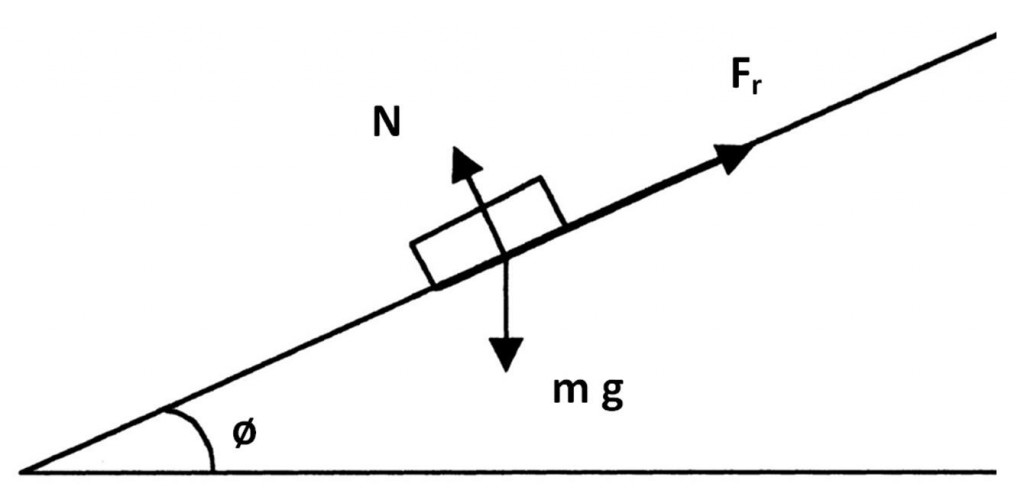

8. Mecanismo físico: plano inclinado

Woodward (2002)[6] presenta un ejemplo tomado de la física: un bloque que se desliza por un plano inclinado, como se muestra en la figura 10.

El bloque está sujeto a dos fuerzas: la fuerza gravitacional debida al peso (m g) y la de la fricción (Fr). La fuerza de fricción obedece a la siguiente relación:

Fr = μr N

en la que μr es el coeficiente de fricción cinética y N es la fuerza normal perpendicular a la dirección del movimiento del bloque:

N = mg cos ø.

Reemplazando N en la fórmula anterior, se tiene que la fuerza de fricción es:

Fr = μr mg cos ø.

La fuerza neta (Fnet) sobre el bloque en el plano es:

Fnet = mg sen ø – mg cos ø.

Y la aceleración a del bloque es dada por:

a = g sen ø – g cos ø.

El mecanismo provoca un cambio regular que es descrito por las ecuaciones.

Figura 10

9. Otros mecanismos

Otros mecanismos han sido expuestos con cierto detalle en artículos relacionados con el neomecanicismo. Por razones de espacio, no pueden ser desarrollados todos ellos aquí, pero se dará a continuación una breve lista para ilustrar la diversidad de mecanismos identificados (o propuestos como tales), que pertenecen a diferentes disciplinas y presentan diferentes niveles de abstracción. Se comentan solo aquellos presentados por neomecanicistas.

Baker (2005) analiza el papel que juega la selección natural en cuatro mecanismos de especiación (aparición de una nueva especie a partir de otra) geográfica y no geográfica. En primer lugar, el mecanismo de “especiación vicariante” desarrollado por Mayr (1942). En segundo lugar, el principio de divergencia y la especiación no geográfica, mecanismo propuesto por Darwin (1958a, 1958b), discutido y desarrollado luego por Dobzhansky (1935, 1937, 1940), llamado “de refuerzo” (reinforcement). En tercer lugar, el mecanismo de especiación denominado “clinal” (clinal), tomado de Endler (1977). Finalmente, el mecanismo de especiación llamado “ecológico”, presentado por Bush (1969).

Barrera (2008) emplea la teoría de juegos para modelar, a partir del ejemplo de los cuidadores de coches (los “no oficiales”, es decir, aquellos que cuidan coches en espacios públicos o de libre acceso a cambio de propinas), el mecanismo social de la confianza. Analiza las distintas definiciones de confianza: la idea es, básicamente, que la suerte de quien confía depende de las acciones o habilidades del otro. Muestra que el mecanismo social de la confianza está relacionado con otros mecanismos, como el de aprendizaje, el de control y el de imitación.

Bechtel y Abrahamsen (2005) presentan algunos ejemplos, además del ya comentado bombeo de sangre del corazón. Por ejemplo, la retroalimentación entre la glicólisis o glucólisis (la obtención de energía, dentro de la célula, como producto de la descomposición de la glucosa en sus componentes simples) y el Ciclo de Krebs (una de las etapas de la respiración celular, que consiste en la oxidación del ácido pirúvico hasta la obtención de CO2 y agua).

Craver y Bechtel (2006a) presentan dos ejemplos: el ejemplo de la trampa para ratones común, y el mecanismo de potencial de acción en neurobiología (el cambio transitorio en el potencial eléctrico a través de la membrana de una célula que da como resultado la conducción de un impulso nervioso).

Craver y Darden (2001) desarrollan el mecanismo neurobiológico de memoria espacial (el recuerdo de la información relativa a los lugares o espacios en que se desenvuelve un animal). Este mecanismo (tal como lo presentan Craver y Darden) es discutido en Von Eckardt y Poland (2004), desde el punto de vista de la neurociencia cognitiva.

Elster (1998) presenta y explica algunos mecanismos que estarían relacionados entre sí (usualmente de a pares) porque, sostiene, son distintos mecanismos que pueden encontrarse en situaciones similares. Ante un deseo que no puede concretarse, puede que cambien las creencias sobre lo que ocurre, o que se adapten los deseos a lo que de hecho ocurre (Elster denomina a estos mecanismos adaptive preferences y wishful thinking respectivamente). Un determinado patrón de conducta P, puede aparecer en dos esferas X e Y de la vida (esferas pública y privada, o política y económica, o económica y religiosa, etc.), según se activen distintos mecanismos: si en X la conducta es P, también lo será en Y (mecanismo que Elster llama spillover effect), si en X la conducta no es P, sí lo será en Y (mecanismo que Elster llama compensation effect), finalmente, si en X la conducta es P, no lo será en Y (mecanismo que Elster llama crowding-out effect). Una experiencia pasada (por ejemplo, una buena experiencia) puede causar una magnificación en la experiencia presente (hacerla parecer mejor de lo que es) o una depreciación por contraste (mecanismos que Elster denomina endowment effect y contrast effect, respectivamente).

Gambetta (1998) analiza tres ejemplos de fenómenos sociales explicados mediante la concatenación de mecanismos: la estabilidad del sistema académico italiano (en la que operan el mecanismo de racionalidad y el mecanismo de selección de tipos), la decisión individual de continuar la educación más allá de los estudios obligatorios (socialmente hay dos mecanismos que operan concatenados, uno involucra la edad de los padres y el otro, el nivel de estudio de los hermanos; los efectos del primer mecanismo son opuestos según se trate de hijos o hijas) y la conformidad o disconformidad generada por el rango en unidades militares (usualmente este fenómeno se explica apelando a un mecanismo llamado “de privación”, es decir, por el estándar de comparación, pero Gambetta muestra que pueden invocarse mecanismos concatenados, como el efecto de imitación, la esperanza excesiva o el incentivo).

Glennan (1996) expone en detalle dos mecanismos: el “mecanismo de flotante” que acciona una válvula que cierra el paso de agua cuando esta llega a cierto nivel en el depósito, y el regulador de voltaje, que interrumpe el paso de energía cuando el valor del voltaje excede el límite máximo o el mínimo.

Glennan (2005) desarrolla y analiza dos modelos mecanicistas de normalización vocal: el modelo propuesto por Gerstman (1968) y el modelo propuesto por Syrdal y Gopal (1986). La normalización vocal es un fenómeno de percepción del habla que estudia la psicología cognitiva. Los modelos pretenden explicar los mecanismos de procesamiento mediante los cuales los oyentes en un auditorio se ajustan a las variaciones en las propiedades acústicas de los sonidos vocálicos de los diferentes oradores.

Hedström (1998) desarrolla un modelo mecanicista (y muestra los resultados de la simulación) para el mecanismo de imitación racional, en entornos estables y en entornos cambiantes. Hay imitación racional cuando la conducta de un actor A se vuelve similar a la de otro actor B como producto de la observación de la conducta de B (A no observa el resultado de la acción de B: en esto difieren imitación y aprendizaje). La simulación demuestra que la imitación resulta una estrategia ventajosa en entornos estables o con cambios producidos por factores exógenos, pero falla cuando el entorno es cambiante.

Hernes (1998) desarrolla un modelo mecanicista para explicar un fenómeno interesante (y analiza las estrategias para evaluar su adecuación): las abejas pican más a las mujeres que a los hombres (o, al menos, son más las mujeres tratadas en hospitales por picadura de abeja).

Kuran (1998) desarrolla los mecanismos sociales de reducción de disonancia. La disonancia es definida, de manera general (Kuran, 1998, p. 148), como la tensión que los individuos experimentan como consecuencia de sus decisiones. La disonancia puede causar incomodidad, angustia o frustración y para reducir la incomodidad individual y/o colectiva, suelen accionarse mecanismos de reducción de disonancia. La fuente de la disonancia puede variar; esto permite distinguir entre disonancia expresiva (la que acompaña la falsificación de preferencias) y disonancia moral (la que se origina por fallar en el cumplimiento de los preceptos morales). Los mecanismos sociales de reducción de disonancia expresiva desarrollados por Kuran son la internalización y la rebelión; los de reducción de disonancia moral son racionalización y redención, y reconstrucción de la moralidad.

Mahoney (2002, 2003) sostiene que hay tres mecanismos sociales altamente desarrollados, que describe sucintamente: elección racional, teoría funcionalista, teoría del poder.

Machamer, Darden y Craver (2000) presentan (no hacen una mera mención, ya que lo describen brevemente, pero tampoco lo desarrollan tan detalladamente como el mecanismo de transmisión química en la sinapsis comentado en el §3 de este capítulo) el mecanismo de reduplicación del ADN (muestran, con una aproximación histórica del problema, el esquema del llamado “dogma central de la biología molecular” en la versión de Watson, 1965).

Ramsey (2008) discute algunos mecanismos de reacción en química orgánica, particularmente, los mecanismos de sustitución nucleófila (en la sustitución nucleófila un átomo –o un grupo de átomos– enlazado a un átomo de carbono es reemplazado por otro átomo –o grupo–).

Schelling (1998) desarrolla y discute un mecanismo social de “contagio” (o de “reclutamiento”), que permite explicar multiplicidad de fenómenos sociales: todos aquellos que repliquen la curva logística (también llamada “ojiva” o “curva S”). Según Marchetti, Meyer y Ausubel (1996) esta curva permite modelar miles de ejemplos, desde la acumulación progresiva del vocabulario de los niños hasta la adopción de maíz híbrido por parte de los granjeros, y, particularmente, modelar ejemplos de la dinámica de poblaciones humanas. Así, muestran que la tasa de fertilidad, la expectativa de vida y la mortalidad infantil de distintas épocas y regiones se ajustan a esta curva. Schelling agrega algunos fenómenos que se adecúan a la curva logística, como la venta de libros, y podrían agregarse otros ejemplos, como los éxitos de cine, teatro o televisión que se propagan “boca a boca” o “boca-oído”.

Sørensen (1998) desarrolla un modelo mecanicista para modelar la competencia por las vacantes: la relación entre la generación de puestos vacantes y los cambios de empleo o cambios en la posición.

Tilly (2004) desarrolla un estudio de casos sobre los mecanismos sociales que cambian los límites sociales (social boundaries) y los que precipitan esos cambios[7]. Son mecanismos de gran importancia, dado que los efectos del cambio de límites sociales suelen incluir secuencias de ataques y defensas. Los mecanismos que precipitan los cambios de límites sociales incluyen encuentros, imposiciones, préstamos, conversaciones e incentivos al cambio. Los mecanismos que causan el cambio de los límites incluyen inscripción-baja, activación-desactivación, transferencia de bando y relocalización.

Los ejemplos citados hasta aquí han sido propuestos por autores que podrían calificarse de neomecanicistas, es decir, por autores que explícitamente reconocen o discuten el rol central de la identificación de mecanismos. Pero tareas como identificar, conceptualizar o modelar mecanismos no son nuevas: en biología molecular (Machamer, Darden y Craver, 2000), en biología evolutiva (Baker, 2005; Skipper y Millstein, 2005), en neurociencia (Bogen, 2008a), en química orgánica (Ramsey, 2008) y en otras ciencias naturales pueden hallarse múltiples ejemplos que muestran que el empleo explícito de mecanismos para la investigación y la explicación es una tarea habitual. Lo novedoso del enfoque es, como se dijo, poner los mecanismos en el centro de atención; reconocerles el valor que de hecho tienen y han tenido para la práctica científica. Ahora bien, cuando se pretende mostrar que parte de la propuesta neomecanicista es reconocer lo que de hecho se ha realizado en ciencia, se buscan ejemplos bien conocidos, muchas veces, acudiendo a la historia de la ciencia para mostrar el proceso que involucró identificar completamente esos mecanismos. Uno de los mecanismos estudiados desde hace más de medio siglo y citado muchas veces como ejemplo es el mecanismo de potencial de acción y las ecuaciones de Hodgkin-Huxley[8]. Distintos trabajos exponen detalladamente el mecanismo desde diferentes ángulos. Lo interesante respecto de este ejemplo es que ha generado desacuerdo entre los neomecanicistas. La discusión gira en torno a tres posturas. Según la primera, se trata de un fenómeno completamente explicado por leyes físicoquímicas (es la postura de, por ejemplo, Weber 2005, 2008). Conforme a la segunda postura, se trata de un fenómeno del cual se tiene meramente un esquema, es decir, un esquema de mecanismo muy general que brinda solo una explicación parcial (es la postura de, por ejemplo, Craver 2007, 2008). Para la tercera postura, se trata de un fenómeno explicado completamente mediante un mecanismo debidamente identificado (es la postura de, por ejemplo, Bogen, 2008b).

En ciencias sociales, que surgieron (en su forma actual) cuando el interés por el mecanicismo clásico ya estaba en decadencia, no está tan claro que se haya estado trabajando en la identificación de mecanismos. Parece que buscar mecanismos no fue, al menos de manera explícita, una tarea de los científicos sociales[9]. Sin embargo, suele señalarse que, implícitamente, ha habido autores que en el momento de explicar fenómenos sociales han recurrido a la descripción de los mecanismos subyacentes. Para ilustrar este punto, pueden tomarse algunas explicaciones dadas en ciencias sociales por autores que no tenían como objetivo explícito identificar mecanismos, y mostrar que estas explicaciones describen usualmente una concatenación de ellos (Hasrun, 2008). A continuación, se dan tres de estos ejemplos.

Elster (1998) presenta como ejemplo un mecanismo que subyace a la explicación que Tocqueville (1969) hace de la relación entre religión y política. Tocqueville pone en duda que pueda haber al mismo tiempo completa independencia religiosa y entera libertad política: quien no tiene fe, ha de obedecer; quien es libre, debe creer. En otras palabras, cuando la necesidad que la gente tiene de autoridad no es satisfecha en el ámbito de la política, la autoridad es buscada entonces en la religión. Por otra parte, los hombres que viven en tiempos de igualdad encuentran difícil ubicar la autoridad intelectual a la que se someten más allá de la humanidad. Según Tocqueville, se puede anticipar que la gente democrática no creerá fácilmente en misiones divinas, que tenderá a reírse de los nuevos profetas, y que deseará encontrar al juez de sus creencias dentro de los límites del género humano. En otras palabras, la falta de autoridad en política tiende a minar la autoridad religiosa más que a respaldarla. Si la democracia brinda demasiadas libertades, la gente tiende a la religión: la religión sería un efecto endógeno de la democracia (efecto del llamado “mecanismo de compensación” que –como se dijo– expone Elster, 1998).

Boudon (1998) muestra que Tocqueville (1955) emplea implícitamente un mecanismo para explicar la causa del estancamiento de la agricultura francesa (en comparación con la inglesa). A fines del siglo XVIII, la centralización administrativa en Francia tiene como consecuencia la aparición de varios puestos de funcionario disponibles, puestos que otorgan prestigio a quienes los ocupan. Por el contrario, en Inglaterra, ni hay tantos puestos de funcionario vacantes ni son tan prestigiosos. Como consecuencia, los terratenientes franceses (pero no los ingleses) ven como una posibilidad atractiva el comprar una posición de funcionario, ya que pueden así incrementar su poder, su prestigio y, posiblemente, su ingreso. Entonces los terratenientes franceses tienen razones para dejar su tierra y servir al rey. Esto provoca una tasa de terratenientes ausentes mayor que en Inglaterra. El ausentismo lleva al alquiler de la tierra a granjeros, hecho que causa en Francia una menor tasa de innovación ya que los granjeros no tienen incentivo para innovar en el cultivo de tierras arrendadas. Esto, finalmente, causa el estancamiento.

El tercer ejemplo (Hernes, 1998) es particularmente interesante, ya que se trata de la predicción[10] de una revolución según Marx y Engels (2003). Marx y Engels identifican a los actores revolucionarios (los trabajadores) y argumentan que serán la gran mayoría en las sociedades industriales. Luego muestran cómo la acción colectiva puede ser incitada por la comunicación y la concentración. Muestran que los trabajadores actuarán a partir de las privaciones y la explotación, y que actuarán conjuntamente debido a la equiparación y a la solidaridad.

Pero la industria, en su desarrollo, no sólo acrecienta el número de proletarios, sino que los concentra en masas considerables; su fuerza aumenta y adquieren mayor conciencia de la misma. Los intereses y las condiciones de existencia de los proletarios se igualan cada vez más a medida que la máquina va borrando las diferencias en el trabajo y reduce el salario, casi en todas partes, a un nivel igualmente bajo. Como resultado de la creciente competencia de los burgueses entre sí y de las crisis comerciales que ella ocasiona, los salarios son cada vez más fluctuantes; el constante y acelerado perfeccionamiento de la máquina coloca al obrero en situación cada vez más precaria; las colisiones individuales entre el obrero y el burgués adquieren más y más el carácter de colisiones entre dos clases. Los obreros empiezan a formar coaliciones contra los burgueses y actúan en común para la defensa de sus salarios. Llegan hasta formar asociaciones permanentes para asegurarse los medios necesarios, en previsión de estos choques circunstanciales. Aquí y allá la lucha estalla en subversión (Marx y Engels, 2003, p. 28).

En este capítulo se desarrollaron en detalle mecanismos de distintas disciplinas, que servirán en capítulos posteriores para ilustrar las discusiones. Todos los ejemplos se tomaron de neomecanicistas, aunque no todos los mecanismos vistos son propuestas originales: muchos son mecanismos conocidos desde hace décadas (o más), y otros son mecanismos que están implícitos en trabajos que tienen más de un siglo. Cada tipo de ejemplo tiene su razón de ser. Los propuestos originalmente por neomecanicistas muestran lo fructífera que puede resultar la propuesta. Los ejemplos que son conocidos explícitamente como mecanismos desde hace tiempo muestran que en ciertos ámbitos es común la investigación dirigida explícitamente hacia ellos (aunque ocupen un rol secundario, en oposición al rol central que pretende otorgarle el neomecanicismo). Finalmente, los ejemplos desarrollados en último término, que están implícitos en la investigación social clásica, muestran que la propuesta neomecanicista no necesariamente se opone a (o es incompatible con) la investigación social propuesta por algunos autores clásicos. Pueden verse, entonces, dos de las intenciones del neomecanicismo: por un lado, despertar el interés por los mecanismos mostrando qué se ha hecho y qué se puede hacer; por otro lado, mostrar que su valor muchas veces fue soslayado porque no se reconocía explícitamente que se estuviese tratando con ellos.

Los ejemplos que se han desarrollado en este capítulo serán utilizados en capítulos posteriores para mostrar las dificultades que encierra la caracterización de mecanismo, y para mostrar cómo se emplean los mecanismos en la explicación, la investigación, etc. Uno de los motivos de la selección de ejemplos fue que sirvieran para las discusiones posteriores. La idea de caracterizar el neomecanicismo en torno a una caracterización correcta de mecanismo implica que la caracterización dada debe ser lo suficientemente flexible o amplia como para servir a distintas disciplinas, y lo suficientemente estricta como para que no todo pueda ser denominado mecanismo. Por eso, en el capítulo siguiente se propondrá una caracterización que servirá para analizar los distintos ejemplos aquí citados.

- Retomado en Craver (2007) y Torres (2009).↵

- “The exact mechanism responsible for these fluxes of Na+ and K+ is still not entirely clear, but the pump is thought to alternately shuttle these ions across the membranes in a cycle fueled by the transfer of a phosphate group from ATP to the pump protein” (Purves, Augustine, Fitzpatrick, Hall, LaMantia, McNamara y Williams, 2004, p. 87). Nótese el empleo de la expresión exact mechanism.↵

- En 1986, momento del informe de Seeley.↵

- El trabajo de Seeley va más allá de lo expuesto aquí: a partir de esto y de la aparición de registros intermedios entre las dos formas de caparazón, Seeley concluye (a esto apunta su trabajo) que la selección natural puede causar transiciones graduales y a la vez rápidas, es decir, que el equilibrio puntuado puede ser explicado por principios darwinianos. De acuerdo con el gradualismo filético de Darwin, los cambios evolutivos en las especies se dan de forma gradual, es decir, paulatina y progresivamente; sin embargo, es común hallar en el registro fósil cambios que parecen súbitos, por no haberse hallado registro de los estadios intermedios de la transición. Estas observaciones llevaron a Steven Jay Gould y Niles Eldredge a postular que los cambios evolutivos pueden ser cambios abruptos, separados por largos períodos sin cambio: según su Teoría de los Equilibrios Puntuados, una especie permanece millones de años sin variación, es decir, en equilibrio, y es reemplazada de manera abrupta por otra especie más exitosa. El registro fósil solo registra los dos puntos de equilibrio, por ser la transición un salto abrupto.↵

- Los trabajos sobre selección natural no se agotan, por supuesto, en los que aquí se citan. Pero los que tratan el tema desde la propuesta neomecanicista (ya sea cuestionándola o apoyándola) se limitan, prácticamente, a los que se incluyen aquí.↵

- El mismo ejemplo en Woodward (2003, cap. 1) y en Weber (2008).↵

- El ejemplo del que parte Tilly (tomado de Grimson, 1999) es un panfleto que invita a una fiesta religiosa boliviana llevada a cabo en Buenos Aires, en 1996. En la invitación, los residentes bolivianos se manifiestan contra los argentinos (especialmente los porteños, que serían inmigrantes o descendientes de inmigrantes, y, por ende, no naturales del lugar) y resaltan la importancia y el orgullo de mantener sus tradiciones incaicas, propias de su región, que –sostienen– se extiende hasta Tucumán.↵

- Hodgkin y Huxley (1952). Comentado en detalle por Schaffner (2008), quien cita además otros trabajos de los autores, en los cuales aparece reiteradamente el término mecanismo. Una aproximación histórica que comenta, además, los antecedentes y discusiones posteriores puede verse en Lamberti y Rodríguez (2007).↵

- Como sostiene van den Berg (1998), tal vez no hubo lugar para la discusión sobre mecanismos porque los grandes referentes de las ciencias sociales (los iniciadores de las distintas tradiciones) estaban abocados a la construcción de grandes teorías generales. En sociología, van den Berg justifica esta afirmación tomando los trabajos de Jürgen Habermas, Pierre Bourdieu, Anthony Giddens y Jeffrey Alexander.↵

- Es interesante porque sería el empleo de un mecanismo para la predicción de un fenómeno y no para su explicación.↵